Quando navighiamo in internet, restiamo interdetti quando vedendo che le pubblicità mostrate in ogni pagina sono sempre rapportate alle nostre precedenti navigazioni, a quello che ha attirato la nostra attenzione sulle rete anche se per un solo istante. E molti di noi, sono sicuro, si sono sentiti come violati, spiati. In realtà si tratta di evolutissimi algoritmi che scandagliano continuamente le nostre abitudini, scoprendo i nostri interessi, le nostre passioni, quello che ci piace guardare. Da questa analisi, propongono poi una serie di opzioni sotto forma di banner, di logo che ricalcano quelli che attraverso l’analisi del nostro comportamento dovrebbero essere le nostre intenzioni. Ma questo è solo l’inizio; sistemi di reti neurali capaci di scandagliare il nostro pensiero, presto saranno in grado di sapere in tempo reale di cosa abbiamo bisogno e di indirizzarci in quella direzione.

Questo tipo di studi, non è recente, perché già nel passato gli scienziati hanno esplorato questi spazi del pensiero, arrivando però solo a definire alcuni aspetti e comunque sempre molto limitati a determinate esperienze. Oggi, questi studi sono riprodotti ad un altro livello da un team di scienziati giapponesi dell’Università di Kyoto i quali sono riusciti a sviluppare una rete neurale capace di decifrare le immagini che il nostro cervello elabora. Mentre nel passato questo tipo di esperimento aveva dato discreti risultati, ma focalizzando l’attenzione o solo su pochissimi oggetti o su volti ben conosciuti, in questo caso, il sistema è in grado di interpretare il pensiero, di leggere le immagini che lo percorrono.

L’esperimento è stato registrato attraverso un sistema di stampa, e i risultati sono stati impressionanti:

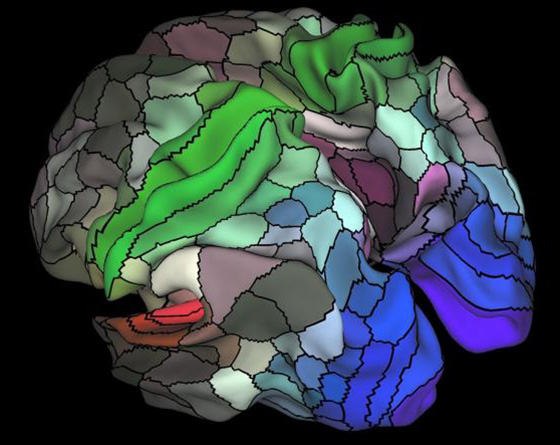

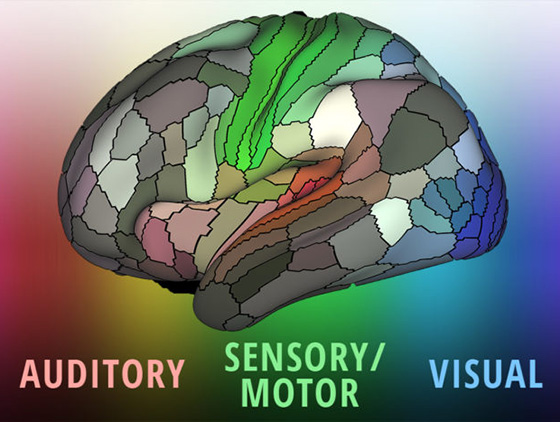

Le immagini mostrate sulla prima riga, sono quello che tre soggetti hanno osservato, mentre nelle tre righe sottostanti, quello che la rete neurale ha ricostruito dal pensiero di ciascuno di loro. Tutto ciò è stato possibile attraverso una tecnica chiamata deep image reconstruction, una serie di algoritmi che agiscono su più passaggi, leggendo il colore, la forma, luci e le ombre dell’immagine. Si tratta di una scansione per livelli gerarchici, come già avviene nel nostro cervello. Gli scienziati hanno lavorato con questi tre soggetti-cavia per 10 mesi, proponendo loro di osservare migliaia di immagini diversificate per categorie, forme geometriche, lettere dell’alfabeto o soggetti naturali come persone ed animali.

Gli scienziati hanno analizzato l’attività celebrale dei tre soggetti per lunghissimo tempo, sia mentre guardavano le immagini sia mentre le immaginavano solamente, sottoponendoli contemporaneamente ad una serie di risonanze magnetiche funzionali (fMRI) per registrare l’attività celebrale. A questo punto inserivano questi dati sulla rete neurale la quale iniziava a ricostruire le immagini basandosi sull’interpretazione di questi dati.

La cosa interessante, è che il sistema è stato istruito con immagini naturali quali persone e animali, ma poi, quando sono state mostrate lettere o oggetti geometrici, è stato in grado di apprendere e di utilizzare quanto già elaborato per la ricostruzione di questi nuovi oggetti mai visti e con caratteristiche completamente diverse.

Lo stesso esperimento condotto sulle immagini non viste ma solo immaginate è riuscito in parte perché queste apparivano molto più imprecise e indefinite, meno vicine comunque agli originali osservati in precedenza.

E’ evidente che bisogna migliorare il sistema di stampa ed elaborazione delle immagini, perché queste sono riconoscibili, ma evidentemente poco chiare. Questo apre scenari inimmaginabili e forse anche inquietanti, ma tutto dipenderà come sempre dall’uso che si deciderà di fare di questa incredibile tecnologia.

| GUARDA I VIDEO: |

| PUOI LEGGERE ANCHE: |